Метаверсище и ИИще

Это не новости, это персональный экспертный взгляд на то, как развивается индустрия ИИ, графики, метаверса, крипты, нейротехнологий и в каком направлении катится все это безобразие.

Для связи: @SergeyTsyptsyn

Для связи: @SergeyTsyptsyn

关联群组

"Метаверсище и ИИще" 群组最新帖子

16.05.202517:34

Это вам за то, что не молитесь.

16.05.202516:53

Tencent Hunyuan Image 2.0 Realtime генерация

16.05.202516:37

Krea Lipsync.

Похоже в Креа завозят липсинк.

Не свой, аггрегируют модель из Hedra.

На входе картиночка и звук\текст.

Надо тестировать разрешение и длительность.

Если нет 720р и длительности выше минуты, то проще в Хедре делать.

@cgevent

Похоже в Креа завозят липсинк.

Не свой, аггрегируют модель из Hedra.

На входе картиночка и звук\текст.

Надо тестировать разрешение и длительность.

Если нет 720р и длительности выше минуты, то проще в Хедре делать.

@cgevent

16.05.202515:17

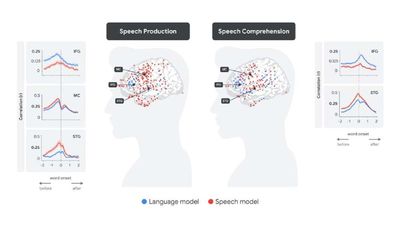

#исследования Некоторое время назад команда Google Research в коллаборации с другими лабораториями опубликовали в Nature исследование, в котором попытались найти сходства между паттернами активации нейронов в реальном мозге во время восприятия и производства речи и внутренними представлениями (эмбеддингами) трансформерной модели, распознающей речь (speech-to-text).

Несмотря на то что мозг и трансформерная модель имеют совершенно разную природу, исследователи обнаружили удивительно стойкую корреляцию. Кроме того, в дальнейшем это позволило предсказывать активность мозга по получаемым эмбеддингам.

✨ Когда человек воспринимает речь, сначала активируются слуховые области коры (например, верхняя височная извилина), и эта активность хорошо предсказывается акустическими эмбеддингами (speech embeddings) модели.

Когда начинается осмысление сказанного, активируются языковые области, такие как область Брока, активность которых хорошо предсказывается языковым эмбеддингами (language embeddings).

✨ При намерении произнести какую-то фразу, наоборот, сначала наблюдается активность в области Брока, которую можно так же предсказать по языковым эмбеддингам.

Затем активируется моторная кора, которая отвечает за подготовку артикуляции — хорошо прогнозируемая акустическими эмбеддингами модели.

Наконец, после произнесения слова, активируются слуховые области, когда человек слышит собственную речь — и это снова соответствует акустическим эмбеддингам.

В блоге Google Research есть хорошие анимации, наглядно объясняющие всю последовательность.

Несмотря на то что мозг и трансформерная модель имеют совершенно разную природу, исследователи обнаружили удивительно стойкую корреляцию. Кроме того, в дальнейшем это позволило предсказывать активность мозга по получаемым эмбеддингам.

✨ Когда человек воспринимает речь, сначала активируются слуховые области коры (например, верхняя височная извилина), и эта активность хорошо предсказывается акустическими эмбеддингами (speech embeddings) модели.

Когда начинается осмысление сказанного, активируются языковые области, такие как область Брока, активность которых хорошо предсказывается языковым эмбеддингами (language embeddings).

✨ При намерении произнести какую-то фразу, наоборот, сначала наблюдается активность в области Брока, которую можно так же предсказать по языковым эмбеддингам.

Затем активируется моторная кора, которая отвечает за подготовку артикуляции — хорошо прогнозируемая акустическими эмбеддингами модели.

Наконец, после произнесения слова, активируются слуховые области, когда человек слышит собственную речь — и это снова соответствует акустическим эмбеддингам.

В блоге Google Research есть хорошие анимации, наглядно объясняющие всю последовательность.

转发自: Сиолошная

Сиолошная

16.05.202515:07

https://openai.com/index/introducing-codex/

— Codex — AI-агент-программист у вас в браузере

— может работать над несколькими задачами

— под капотом модель Codex-1 , основанная на o3

— можно подключать свой GitHub аккаунт, чтобы давать доступ агенту

— Plus юзеры пока не получат доступ, выкатят скоро.

— For developers building with codex-mini-latest (МИНИ), the model is available on the Responses API and priced at $1.50 per 1M input tokens and $6 per 1M output tokens, with a 75% prompt caching discount.

— Codex — AI-агент-программист у вас в браузере

— может работать над несколькими задачами

— под капотом модель Codex-1 , основанная на o3

— можно подключать свой GitHub аккаунт, чтобы давать доступ агенту

— Plus юзеры пока не получат доступ, выкатят скоро.

— For developers building with codex-mini-latest (МИНИ), the model is available on the Responses API and priced at $1.50 per 1M input tokens and $6 per 1M output tokens, with a 75% prompt caching discount.

16.05.202510:37

🌟 Поддержать канал

И поздравить нейродеда

И поздравить нейродеда

16.05.202510:33

Уюхуху, Неродед-сорокет!

Ни разу не закупал рекламу, не участвовал в папках, шмапках, аппках, рос органикой, и вот достукался.

Я не загоняю этим каналом пользователей на свои курсы, сайты, проекты, а пишу по двум причинам:

1. Чтобы на забыть. Написал про что-то - лучше запомнил.

2. Мне нравится писать. Я могу позволить себе писать с ошибками, как гопник, а могу писать грамотно (у меня та самая врожденная грамотность, а на деле особый вид памяти). Есть чувство языка, которое приносит мне, и надеюсь вам, удовольствие.

Если вам тоже нравится, можете размахнуться и со всей дури жбакнуть по кнопке Донат.

Либо криптой или Тонами.

Либо звездами, по моде.

В коменты наваливаем позитив.

А я продолжу...

@cgevent

Ни разу не закупал рекламу, не участвовал в папках, шмапках, аппках, рос органикой, и вот достукался.

Я не загоняю этим каналом пользователей на свои курсы, сайты, проекты, а пишу по двум причинам:

1. Чтобы на забыть. Написал про что-то - лучше запомнил.

2. Мне нравится писать. Я могу позволить себе писать с ошибками, как гопник, а могу писать грамотно (у меня та самая врожденная грамотность, а на деле особый вид памяти). Есть чувство языка, которое приносит мне, и надеюсь вам, удовольствие.

Если вам тоже нравится, можете размахнуться и со всей дури жбакнуть по кнопке Донат.

Либо криптой или Тонами.

Либо звездами, по моде.

В коменты наваливаем позитив.

А я продолжу...

@cgevent

16.05.202507:25

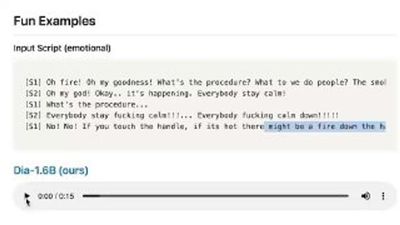

KeySync: Автодубляж.

На входе НЕ картинка, на входе видео с речью на любом языке. И аудио-файл на другом языке.

На выходе - переозвучка с попаданием в губы.

Основная фишка - уменьшение ошибок и потерь в эмоциях при переозвучке.

Код есть, все есть. Демо тоже, но у меня не завелось.

Авторы из Польши во главе с Антоном Бигдатым.

https://antonibigata.github.io/KeySync/

@cgevent

На входе НЕ картинка, на входе видео с речью на любом языке. И аудио-файл на другом языке.

На выходе - переозвучка с попаданием в губы.

Основная фишка - уменьшение ошибок и потерь в эмоциях при переозвучке.

Код есть, все есть. Демо тоже, но у меня не завелось.

Авторы из Польши во главе с Антоном Бигдатым.

https://antonibigata.github.io/KeySync/

@cgevent

16.05.202506:49

Нейродедовость

Промпт:

Подставляете вместо subject любую нейрохрень. Можете потом забрать раскучерявленный промпт из chatGPT и кормить его в другие генераторы.

Фас - Gemini\Imagen3

3/4 - chatGPT

Люблю частицы.

И большого Лебовскаго.

@cgevent

Промпт:

A stylized figure of a [SUBJECT] made of glowing, abstract red and orange energy particles, with radiant and bright illumination effects, set against a deep, dark background. The subject appears translucent and ethereal, with dynamic lighting, shimmering, and a sense of cosmic elegance in portrait modeПодставляете вместо subject любую нейрохрень. Можете потом забрать раскучерявленный промпт из chatGPT и кормить его в другие генераторы.

Фас - Gemini\Imagen3

3/4 - chatGPT

Люблю частицы.

И большого Лебовскаго.

@cgevent

16.05.202506:35

А вот и первые ласточки применения ИИ в новой нормальной рекламе.

Гугл кормит свои видосы в Гемини.

Она смотрит, где юзер больше всего залипает, так называемые Пиковые Точки.

В каждом видео есть моменты, которые требуют наибольшего внимания, и зрители часто переходят сразу к этому разделу или вскоре уходят. Эти моменты также были бы самым идеальным местом для показа рекламы и получения наибольшего охвата, поэтому YouTube вводит «Peak Points».

Гемини теперь знает про вас не только что вы смотрите, а как вы смотрите и на что вы смотрите. И ну вставлять рекламу.

1Xbet такие: жалкие плагиаторы.

https://9to5google.com/2025/05/15/youtube-ads-gemini-peak-points-placement/

@cgevent

Гугл кормит свои видосы в Гемини.

Она смотрит, где юзер больше всего залипает, так называемые Пиковые Точки.

В каждом видео есть моменты, которые требуют наибольшего внимания, и зрители часто переходят сразу к этому разделу или вскоре уходят. Эти моменты также были бы самым идеальным местом для показа рекламы и получения наибольшего охвата, поэтому YouTube вводит «Peak Points».

Гемини теперь знает про вас не только что вы смотрите, а как вы смотрите и на что вы смотрите. И ну вставлять рекламу.

1Xbet такие: жалкие плагиаторы.

https://9to5google.com/2025/05/15/youtube-ads-gemini-peak-points-placement/

@cgevent

16.05.202506:18

Manus: Думающий генератор картинок.

Про Мануса не написал только ленивый - это самый распиаренный AI Agent (не путать с ассистентом), которому можно поставить задачу и он пойдет решать ея в интернетик. Есть уже опенсорсные аналоги, ибо это по сути оркестратор API вызовов разных нейросеток (в основном платных) и платить вам придется по любому.

Очень грубое отличие агента от ассистента состоит в том, что агент делает НЕСКОЛЬКО действий в ответ на поставленную задачу(промпт), не спрашивая у вас мнения, какие действия и в какой последовательности предпринять. "Сам решает" какие апи вызовы дергать, и, главное, в какой последовательности.

Вот держите черри-пикнутое демо работы Мануса, включающее действия по генерации картинок. То есть картиники здесь генерятся НЕ по промпту, и НЕ по команде "сгенери картинку, тварь", а как внутренний этап решения более общей задачи.

Тут 4 задачи и все довольно разные. Подбор мебели из Икеи по входной фотке (генерация картинки с мебелью, как часть задачи), маркетинговая стратегия нового продукта (внутри происходит дизайн и генерация бутылки, потом дизайн и генерация постеров, все как промежуточные этапы), третий кейс самый прикольный - вот четыре фотки моего разного барахла(4 единицы), которое я хочу продать в интернетике - Манус берет фотки, генерит по ним описания и новые фотки, и создает веб-страницу, ибо юзер попросил продать всю эту шнягу. Генерация картинок, часть процесса. Последний кейс банальный - книжка с картинками на заданную тему. Там Манус сам решает за картинки, промпты, частоту, объем текста.

Я посмотрел покадрово три раза. Не увидел, что они используют для генерации картинок. В принципе неважно, суть басни в том, что он САМ решает, что генерить, как генерить, где генерить, пишет промпты, валидирует, возможно генерит заново. Думает в общем.

За сам Манус: его сейчас открыли для всех, 1000 кредитов за новый акк, и 300 в день. Но это ни о чем. Он очень дорогой и очень медленный. Юзеры пишут, что задача может решаться 16 дней, а счет приходит на тысячи и тысячи кредитов.

Все как у людей, все как у людей. Долго, дорого, с ошибками.

Но это пока. Стоимость аренды Мануса уже приближается к стоимость работы фрилансера с Фивера. Пройдет год и разница в цене будет 1:100. Вот тогда поговорим.

https://manus.im/

@cgevent

Про Мануса не написал только ленивый - это самый распиаренный AI Agent (не путать с ассистентом), которому можно поставить задачу и он пойдет решать ея в интернетик. Есть уже опенсорсные аналоги, ибо это по сути оркестратор API вызовов разных нейросеток (в основном платных) и платить вам придется по любому.

Очень грубое отличие агента от ассистента состоит в том, что агент делает НЕСКОЛЬКО действий в ответ на поставленную задачу(промпт), не спрашивая у вас мнения, какие действия и в какой последовательности предпринять. "Сам решает" какие апи вызовы дергать, и, главное, в какой последовательности.

Вот держите черри-пикнутое демо работы Мануса, включающее действия по генерации картинок. То есть картиники здесь генерятся НЕ по промпту, и НЕ по команде "сгенери картинку, тварь", а как внутренний этап решения более общей задачи.

Тут 4 задачи и все довольно разные. Подбор мебели из Икеи по входной фотке (генерация картинки с мебелью, как часть задачи), маркетинговая стратегия нового продукта (внутри происходит дизайн и генерация бутылки, потом дизайн и генерация постеров, все как промежуточные этапы), третий кейс самый прикольный - вот четыре фотки моего разного барахла(4 единицы), которое я хочу продать в интернетике - Манус берет фотки, генерит по ним описания и новые фотки, и создает веб-страницу, ибо юзер попросил продать всю эту шнягу. Генерация картинок, часть процесса. Последний кейс банальный - книжка с картинками на заданную тему. Там Манус сам решает за картинки, промпты, частоту, объем текста.

Я посмотрел покадрово три раза. Не увидел, что они используют для генерации картинок. В принципе неважно, суть басни в том, что он САМ решает, что генерить, как генерить, где генерить, пишет промпты, валидирует, возможно генерит заново. Думает в общем.

За сам Манус: его сейчас открыли для всех, 1000 кредитов за новый акк, и 300 в день. Но это ни о чем. Он очень дорогой и очень медленный. Юзеры пишут, что задача может решаться 16 дней, а счет приходит на тысячи и тысячи кредитов.

Все как у людей, все как у людей. Долго, дорого, с ошибками.

Но это пока. Стоимость аренды Мануса уже приближается к стоимость работы фрилансера с Фивера. Пройдет год и разница в цене будет 1:100. Вот тогда поговорим.

https://manus.im/

@cgevent

16.05.202504:19

Сегодня в 18:00 по мск openAI будет троллить программистов и Гугл.

1. Почему программистов.

Потому что они пишут в своем твитторе: "это для разработчиков и тех, кто собирается ими стать".

2. Почему Гугл.

Потому что они постоянно делают лайфстрим с чем-то очень эффектным как раз накануне Google I/O или накануне гугловых анонсов.

@cgevent

1. Почему программистов.

Потому что они пишут в своем твитторе: "это для разработчиков и тех, кто собирается ими стать".

2. Почему Гугл.

Потому что они постоянно делают лайфстрим с чем-то очень эффектным как раз накануне Google I/O или накануне гугловых анонсов.

@cgevent

15.05.202521:05

Пурдюбик кубик.

Это дикое сломо. В реальности робат собирает кубик Рубика за, внимание 0.103 секунды ИЗ ЛЮБОГО положения граней. С помощью computer vision.

Посмотрите момент вначале и в конце.

Итак.

Студенты Университета Purdue построили робота Purdubik's Cube, который собрал(решив по дороге) кубик Рубика за 0,103 секунды, установив 21 апреля 2025 года мировой рекорд Гиннесса.

Робот использует комп. зрение и алгоритмы для решения кубика в режиме реального времени, а не только заранее запрограммированные движения.

Ну, за рекорды.

@cgevent

Это дикое сломо. В реальности робат собирает кубик Рубика за, внимание 0.103 секунды ИЗ ЛЮБОГО положения граней. С помощью computer vision.

Посмотрите момент вначале и в конце.

Итак.

Студенты Университета Purdue построили робота Purdubik's Cube, который собрал(решив по дороге) кубик Рубика за 0,103 секунды, установив 21 апреля 2025 года мировой рекорд Гиннесса.

Робот использует комп. зрение и алгоритмы для решения кубика в режиме реального времени, а не только заранее запрограммированные движения.

Ну, за рекорды.

@cgevent

15.05.202520:14

11labs сделала очень забавный и простой продукт.

SB-1 Infinite Soundboard.

Это типа драм-машинки, только вы можете генерить звуки промптами и добавлять их на кнопки.

А потом смешивать их.

Бесконечный источник закадровых шумов.

https://elevenlabs.io/sound-effects/soundboard

@cgevent

SB-1 Infinite Soundboard.

Это типа драм-машинки, только вы можете генерить звуки промптами и добавлять их на кнопки.

А потом смешивать их.

Бесконечный источник закадровых шумов.

https://elevenlabs.io/sound-effects/soundboard

@cgevent

记录

16.05.202523:59

40K订阅者12.04.202523:59

300引用指数11.05.202513:43

17.1K每帖平均覆盖率25.01.202523:59

14.6K广告帖子的平均覆盖率09.02.202523:59

25.84%ER11.05.202513:42

43.11%ERR登录以解锁更多功能。