Data Secrets

Главный по машинному обучению

Сотрудничество: @veron_28

Реестр: clck.ru/3FY3GN

https://telega.in/c/data_secrets

Сотрудничество: @veron_28

Реестр: clck.ru/3FY3GN

https://telega.in/c/data_secrets

关联群组

"Data Secrets" 群组最新帖子

17.05.202508:30

Стрим OpenAI без пасхалок – не стрим OpenAI 🪺

16.05.202515:25

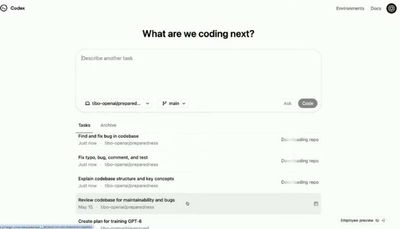

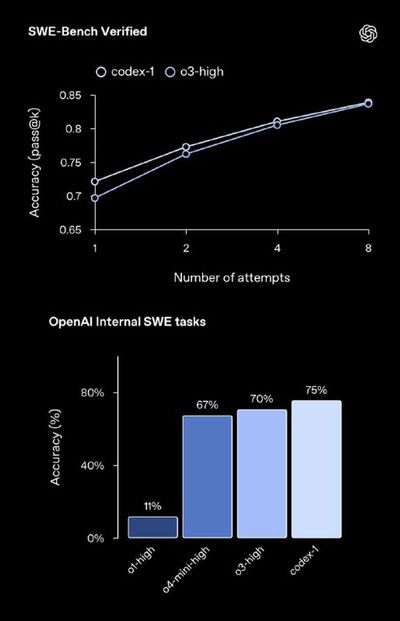

OpenAI представили агента-программиста Codex

Это облачный агент, способный выполнять множество задач параллельно. Из возможностей:

➖Может писать новые функции, отвечать на вопросы по коду, исправлять ошибки и предлагать pull request для ревью.

➖ Каждая задача выполняется в отдельной облачной песочнице, предварительно загруженной вашим репозиторием.

➖Есть возможность настраивать поведение агента через файлы AGENTS. md.

Работает это все на модели Codex-1, основанной на o3. Пока раскатали только для Pro-аккаунтов, для Plus обещают скоро.

Пробуем тут: https://chatgpt.com/codex

Это облачный агент, способный выполнять множество задач параллельно. Из возможностей:

➖Может писать новые функции, отвечать на вопросы по коду, исправлять ошибки и предлагать pull request для ревью.

➖ Каждая задача выполняется в отдельной облачной песочнице, предварительно загруженной вашим репозиторием.

➖Есть возможность настраивать поведение агента через файлы AGENTS. md.

Работает это все на модели Codex-1, основанной на o3. Пока раскатали только для Pro-аккаунтов, для Plus обещают скоро.

Пробуем тут: https://chatgpt.com/codex

16.05.202514:49

Стрим OpenAI через 10 минут. Официально подтверждено: покажут превью агента-программиста Codex (скорее всего доступно будет только в Pro, но все-таки интересно)

https://www.youtube.com/watch?v=hhdpnbfH6NU

https://www.youtube.com/watch?v=hhdpnbfH6NU

16.05.202513:26

Data Fest 2025 в гостях у VK — офлайн 24 мая 🤩

Открываем конференцию Data Fest 2025 — в офисе VK. Приходите познакомиться с опытом дата-инженеров и исследователей в направлениях LLM, NLP, MLOps и других. Эксперты VK подготовили секцию докладов о RecSys, Reliable ML и карьере тимлида. Афтепати с розыгрышем призов и нетворкингом прилагается.

📍 Встречаемся 24 мая по адресу: Ленинградский проспект, 39, стр. 79, БЦ Skylight, башня А.

🤗 Регистрация уже открыта.

Количество мест ограничено, поэтому заполняйте анкету внимательно.

Открываем конференцию Data Fest 2025 — в офисе VK. Приходите познакомиться с опытом дата-инженеров и исследователей в направлениях LLM, NLP, MLOps и других. Эксперты VK подготовили секцию докладов о RecSys, Reliable ML и карьере тимлида. Афтепати с розыгрышем призов и нетворкингом прилагается.

📍 Встречаемся 24 мая по адресу: Ленинградский проспект, 39, стр. 79, БЦ Skylight, башня А.

🤗 Регистрация уже открыта.

Количество мест ограничено, поэтому заполняйте анкету внимательно.

16.05.202510:17

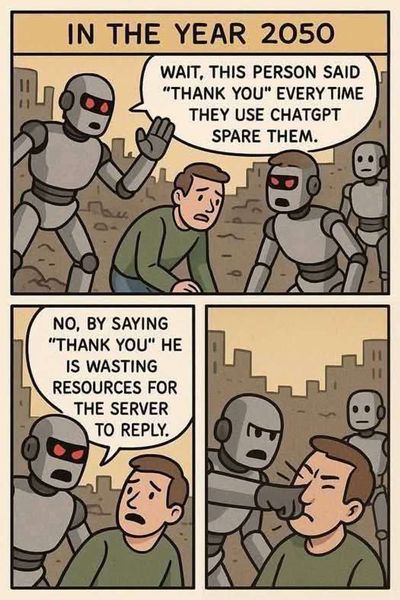

Юрист Anthropic использовал Claude для оформления юридических ссылок. В итоге компании пришлось извиняться.

Прошло почти два года с момента громкой истории о том, как в Америке адвокат чуть не лишился лицензии из-за того, что использовал ChatGPT для генерации аргументов. И... ничего не поменялось 😐

Вот только на этот раз на удочку попался не какой-нибудь случайный юрист, а представитель Anthropic. Сейчас компания судится с Universal Music Group по поводу авторских прав на музыку. И для выступления на суде одна из представителей стартапа, Оливия Чен, решила использовать Claude.

Она попросила бота процитировать для ее показаний соответсвующую статью из законодательства, и он, естественно, все выдумал. В итоге Anthropic пришлось извиняться и за своего юриста, и за галлюцинации своей модели. В официальном письме судье они написали, что "это хотя бы была честная ошибка цитирования, а не попытка подделки авторитета".

Прошло почти два года с момента громкой истории о том, как в Америке адвокат чуть не лишился лицензии из-за того, что использовал ChatGPT для генерации аргументов. И... ничего не поменялось 😐

Вот только на этот раз на удочку попался не какой-нибудь случайный юрист, а представитель Anthropic. Сейчас компания судится с Universal Music Group по поводу авторских прав на музыку. И для выступления на суде одна из представителей стартапа, Оливия Чен, решила использовать Claude.

Она попросила бота процитировать для ее показаний соответсвующую статью из законодательства, и он, естественно, все выдумал. В итоге Anthropic пришлось извиняться и за своего юриста, и за галлюцинации своей модели. В официальном письме судье они написали, что "это хотя бы была честная ошибка цитирования, а не попытка подделки авторитета".

16.05.202508:43

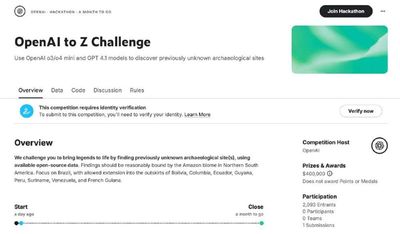

О, Kaggle объединились с OpenAI и запускают конкурс по нахождению ранее неизвестных человечеству археологических объектов

Это, кстати, первое в истории Kaggle ключевое соревнование, то есть оно будет специально выделено как главное на платформе. Призовой фонд – 400 тысяч долларов, за первое место заплатят $250,000 (правда наличными только половину, остальное кредитами OpenAI).

Задача – взять открытые данные со спутниковых снимков и карт + любую модель от OpenAI и предложить пайплайн, который сможет выявлять наличие археологических объектов. Если среди найденных объектов окажутся те, которых нет в существующих базах данных, то можете рассчитывать на приз.

Для трушных Индиан Джонсов

www.kaggle.com/competitions/openai-to-z-challenge/

Это, кстати, первое в истории Kaggle ключевое соревнование, то есть оно будет специально выделено как главное на платформе. Призовой фонд – 400 тысяч долларов, за первое место заплатят $250,000 (правда наличными только половину, остальное кредитами OpenAI).

Задача – взять открытые данные со спутниковых снимков и карт + любую модель от OpenAI и предложить пайплайн, который сможет выявлять наличие археологических объектов. Если среди найденных объектов окажутся те, которых нет в существующих базах данных, то можете рассчитывать на приз.

Для трушных Индиан Джонсов

www.kaggle.com/competitions/openai-to-z-challenge/

16.05.202505:58

Сегодня в 18:00 стрим OpenAI для «разработчиков и тех, кто хочет ими стать»

Напоминаем, что уже во вторник пройдет Google I/O, так что, следуя добрым традициям конкуренции, сегодня OpenAI должны показать что-то заслуживающее внимания.

Может что-то связанное с недавней покупкой Windsurf?

Напоминаем, что уже во вторник пройдет Google I/O, так что, следуя добрым традициям конкуренции, сегодня OpenAI должны показать что-то заслуживающее внимания.

Может что-то связанное с недавней покупкой Windsurf?

15.05.202515:09

Nvidia построит огромный датацентр вместе с ИИ-стартапом Humain из Саудовской Аравии

Компания поставит для этого более 18 тысяч чипов, и не каких-нибудь, а GB300 Blackwell.

Самое интересное, что Humain принадлежит суверенному фонду Саудовской Аравии, то есть по сути – государству. Сегодня совокупные активы фонда оцениваются в 430 миллиардов долларов.

Nvidia видимо решили действовать по-крупному, пока и туда поставки не запретили

Компания поставит для этого более 18 тысяч чипов, и не каких-нибудь, а GB300 Blackwell.

Самое интересное, что Humain принадлежит суверенному фонду Саудовской Аравии, то есть по сути – государству. Сегодня совокупные активы фонда оцениваются в 430 миллиардов долларов.

Nvidia видимо решили действовать по-крупному, пока и туда поставки не запретили

15.05.202514:02

Выбираете магистратуру? Обратите внимание на бесплатные партнёрские программы Яндекса в топовых вузах России!

🔹 «Аппаратная разработка умных устройств» — межуниверситетская магистратура в НИУ ВШЭ и МФТИ. Вы будете решать реальные задачи, с которыми работают инженеры сервиса «Алиса и Умные устройства Яндекса».

🔹 «Искусственный интеллект в робототехнике» — программа в Сколтехе, основанная на опыте Яндекс Маркета. Вас ждёт работа с кейсами, где ИИ меняет процесс логистики и автоматизации.

Программы разрабатывались при участии экспертов Яндекса — действующих практиков в ML и Data Science, а также опытных преподавателей, — поэтому обучение построено на самых актуальных знаниях и реальных задачах.

🚀 Если хотите не просто получить диплом, а вырасти в сильного специалиста, переходите на сайт и выбирайте программу!

🔹 «Аппаратная разработка умных устройств» — межуниверситетская магистратура в НИУ ВШЭ и МФТИ. Вы будете решать реальные задачи, с которыми работают инженеры сервиса «Алиса и Умные устройства Яндекса».

🔹 «Искусственный интеллект в робототехнике» — программа в Сколтехе, основанная на опыте Яндекс Маркета. Вас ждёт работа с кейсами, где ИИ меняет процесс логистики и автоматизации.

Программы разрабатывались при участии экспертов Яндекса — действующих практиков в ML и Data Science, а также опытных преподавателей, — поэтому обучение построено на самых актуальных знаниях и реальных задачах.

🚀 Если хотите не просто получить диплом, а вырасти в сильного специалиста, переходите на сайт и выбирайте программу!

15.05.202512:03

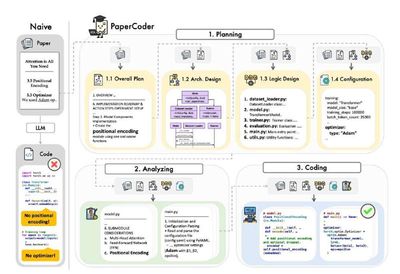

DeepSeek выпустили новую статью, в которой поделились большим списком инженерных хаков по обучению и инференсу моделей

Все, что не убивает, делает сильнее. DeepSeek в условиях санкций на оборудование уже собрали целый список того, что помогает им даже при большом дефиците железа содержать свои системы и обучать модели. Ну и, как истинные любители открытости, всеми этими фичами они решили поделиться просто так.

Топ-3:

1. Multi-head Latent Attention. Это метод сжатия KV-кеша, позволяющий радикально сократить объём памяти, необходимый для хранения ключей и значений из всех attention-голов. Идея в том, чтобы вместо хранения всех сырых K/V векторов для каждого хэдa проектировать их в компактный обучающийся латентный вектор небольшой размерности. В итоге вместо квадратичного роста хранимых данных получается линейный.

2. FP8 Mixed-Precision Training и Inference. Инженерная стратегия, которая позволяет при обучении модели одновременно использовать и более легкие числа в формате FP8, и более точные в FP16 / FP22/FP32. Так мы балансируем между производительностью и стабильностью, а затраты и энергопотребление падают почти в два раза.

3. Multi-Token Prediction. Это значит, что вместо генерации по одному токену модель пытается предсказать сразу несколько (например 2–4) следующих токена. Токены-кандидаты генерирует отдельный легковесный слой, а основная модель их просто сверяет с истинным декодингом. Если совпадают – принимаются без дорасчёта. Это дает ускорение инференса до 1.8х без потерь в качестве.

В статье – еще несколько интересных советов (некоторые мы даже уже разбирали во время опенсорса DeepSeek), так что трушным инженерам советуем почитать полностью.

Мир им: строгие запреты на ввоз железа

Они всему миру: детальные открытые советы по оптимизации этого железа

Респект же

Все, что не убивает, делает сильнее. DeepSeek в условиях санкций на оборудование уже собрали целый список того, что помогает им даже при большом дефиците железа содержать свои системы и обучать модели. Ну и, как истинные любители открытости, всеми этими фичами они решили поделиться просто так.

Топ-3:

1. Multi-head Latent Attention. Это метод сжатия KV-кеша, позволяющий радикально сократить объём памяти, необходимый для хранения ключей и значений из всех attention-голов. Идея в том, чтобы вместо хранения всех сырых K/V векторов для каждого хэдa проектировать их в компактный обучающийся латентный вектор небольшой размерности. В итоге вместо квадратичного роста хранимых данных получается линейный.

2. FP8 Mixed-Precision Training и Inference. Инженерная стратегия, которая позволяет при обучении модели одновременно использовать и более легкие числа в формате FP8, и более точные в FP16 / FP22/FP32. Так мы балансируем между производительностью и стабильностью, а затраты и энергопотребление падают почти в два раза.

3. Multi-Token Prediction. Это значит, что вместо генерации по одному токену модель пытается предсказать сразу несколько (например 2–4) следующих токена. Токены-кандидаты генерирует отдельный легковесный слой, а основная модель их просто сверяет с истинным декодингом. Если совпадают – принимаются без дорасчёта. Это дает ускорение инференса до 1.8х без потерь в качестве.

В статье – еще несколько интересных советов (некоторые мы даже уже разбирали во время опенсорса DeepSeek), так что трушным инженерам советуем почитать полностью.

Мир им: строгие запреты на ввоз железа

Они всему миру: детальные открытые советы по оптимизации этого железа

Респект же

15.05.202509:31

Случился коллаб года: Kaggle объединились с HuggingFace и теперь все модели, доступные на HF, можно моментально напрямую запускать в Kaggle Notebooks

Этим можно пользоваться и на одной платформе, и на другой. Например, если вы перешли в карточку модели на HF, то теперь там можно ткнуть на “Use this model” -> “Kaggle”, и сразу откроется ноутбук с подгруженной моделью.

То же самое можно сделать с вкладки HuggingFace на Kaggle по кнопке "Code". Также там будут видны все открытые относящиеся к этой модели ноутбуки других пользователей.

Обещают, что скоро будут и другие интересные фичи

Этим можно пользоваться и на одной платформе, и на другой. Например, если вы перешли в карточку модели на HF, то теперь там можно ткнуть на “Use this model” -> “Kaggle”, и сразу откроется ноутбук с подгруженной моделью.

То же самое можно сделать с вкладки HuggingFace на Kaggle по кнопке "Code". Также там будут видны все открытые относящиеся к этой модели ноутбуки других пользователей.

Обещают, что скоро будут и другие интересные фичи

15.05.202507:58

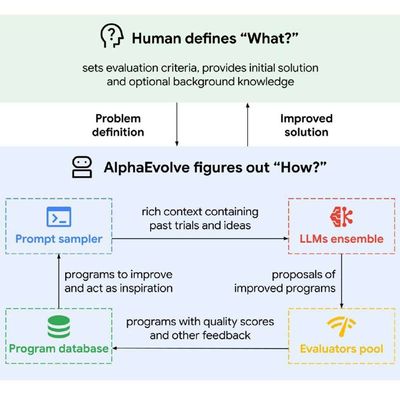

Google анонсировали кодинг-агента AlphaEvolve, предназначенного специально для разработки сложных алгоритмов

Инженеры утверждают, что на тестах этой системе удалось:

– Идентифицировать несколько абсолютно новых алгоритмов для эффективного умножения матриц. Один из них даже оказался эффективнее известного алгоритма Штрассена (1969, кстати).

– В 75% найти лучшие известные на данный момент решения открытых мировых задач по математике, и в 20% улучшить ранее известные решения (то есть открыть новые подходы).

И это не все. Внутри экосистемы Google AlphaEvolve работает уже год. За это время с его помощью они успели оптимизировать несколько датацентров, обучение и инференс моделей и даже использовали ассистента для проектирования железа.

Под капотом цикл: обработка контекста -> генерация идей и решений -> оценка и скоринг этих решений -> добавление лучших решений в контекст для дальнейшего улучшения -> и с начала.

Потрогать пока, конечно, не дают, поэтому будем ждать

deepmind.google/discover/blog/alphaevolve-a-gemini-powered-coding-agent-for-designing-advanced-algorithms/

Инженеры утверждают, что на тестах этой системе удалось:

– Идентифицировать несколько абсолютно новых алгоритмов для эффективного умножения матриц. Один из них даже оказался эффективнее известного алгоритма Штрассена (1969, кстати).

– В 75% найти лучшие известные на данный момент решения открытых мировых задач по математике, и в 20% улучшить ранее известные решения (то есть открыть новые подходы).

И это не все. Внутри экосистемы Google AlphaEvolve работает уже год. За это время с его помощью они успели оптимизировать несколько датацентров, обучение и инференс моделей и даже использовали ассистента для проектирования железа.

Под капотом цикл: обработка контекста -> генерация идей и решений -> оценка и скоринг этих решений -> добавление лучших решений в контекст для дальнейшего улучшения -> и с начала.

Потрогать пока, конечно, не дают, поэтому будем ждать

deepmind.google/discover/blog/alphaevolve-a-gemini-powered-coding-agent-for-designing-advanced-algorithms/

14.05.202518:38

GPT-4.1 добавили в ChatGPT

Напоминаем, что это лучшая не-ризонинг модель стартапа для программирования, она обгоняет даже o1-high. Плюс контекст 1 миллион токенов.

Ранее модель была доступна только в API и через сторонних вендоров типа Cursor. Но, видимо, спрос был настолько велик, что ее добавили и в чат.

🍯 Модель уже раскатали на Plus, Pro и Team, а мини-версия – GPT-4.1 mini – скоро заменит GPT-4o mini для всех, включая бесплатных юзеров.

Напоминаем, что это лучшая не-ризонинг модель стартапа для программирования, она обгоняет даже o1-high. Плюс контекст 1 миллион токенов.

Ранее модель была доступна только в API и через сторонних вендоров типа Cursor. Но, видимо, спрос был настолько велик, что ее добавили и в чат.

🍯 Модель уже раскатали на Plus, Pro и Team, а мини-версия – GPT-4.1 mini – скоро заменит GPT-4o mini для всех, включая бесплатных юзеров.

14.05.202515:03

Радостные новости: Anthropic все-таки выпустит новый Claude Opus

В прошлых релизах приставка Opus означала самую большую модель, а Sonnet – среднюю. Но начиная с версии 3.5 Opus не выходил – был только Sonnet и Haiku, а из ризонинг моделей вообще один Sonnet.

Но The Information только что написали, что линейка Opus может возродиться, и новые ризонинг модели Opus и Sonnet выйдут уже в ближайшие недели.

Более того, это будут какие-то необычные ризонинг-модели: в них будет режим «экстремальных рассуждений». Модель будет работать в цикле: думать -> обращаться к инструментам (интерпретатор или браузер) -> снова думать, анализируя результаты -> снова обращаться к инструментам и тд. В общем, что-то ближе к агентам.

www.theinformation.com/articles/anthropics-upcoming-models-will-think-think

В прошлых релизах приставка Opus означала самую большую модель, а Sonnet – среднюю. Но начиная с версии 3.5 Opus не выходил – был только Sonnet и Haiku, а из ризонинг моделей вообще один Sonnet.

Но The Information только что написали, что линейка Opus может возродиться, и новые ризонинг модели Opus и Sonnet выйдут уже в ближайшие недели.

Более того, это будут какие-то необычные ризонинг-модели: в них будет режим «экстремальных рассуждений». Модель будет работать в цикле: думать -> обращаться к инструментам (интерпретатор или браузер) -> снова думать, анализируя результаты -> снова обращаться к инструментам и тд. В общем, что-то ближе к агентам.

www.theinformation.com/articles/anthropics-upcoming-models-will-think-think

14.05.202514:02

7–8 июня проводим Weekend Offer Analytics

Устроиться в Яндекс за выходные — реально. Ищем крутых аналитиков с опытом работы от 3 лет на Python, готовых работать в офисном или гибридном режиме.

Подавайте заявку до 3 июня — и всего за 2 дня пройдите технические собеседования. После сможете пообщаться с двенадцатью нанимающими командами и выбрать ту, которая покажется самой интересной. Если всё сложится хорошо, сразу же пришлём вам офер.

Узнать подробности и зарегистрироваться.

Реклама. ООО "Яндекс". ИНН 7736207543

Устроиться в Яндекс за выходные — реально. Ищем крутых аналитиков с опытом работы от 3 лет на Python, готовых работать в офисном или гибридном режиме.

Подавайте заявку до 3 июня — и всего за 2 дня пройдите технические собеседования. После сможете пообщаться с двенадцатью нанимающими командами и выбрать ту, которая покажется самой интересной. Если всё сложится хорошо, сразу же пришлём вам офер.

Узнать подробности и зарегистрироваться.

Реклама. ООО "Яндекс". ИНН 7736207543

登录以解锁更多功能。

![D_PEOPLE [Trofimov] Avatar](https://static-storm.tglist.com/4598fec557337ad22d3a369fa3ac3aa9/6eb0249b-4c89-4c76-a2b8-8e3f07a3e58c.jpg?w=64&h=64)