Nairaland Pulse | News

Анатолий Шарий

Реальний Київ | Украина

Мир сегодня с "Юрий Подоляка"

Труха⚡️Україна

Николаевский Ванёк

Инсайдер UA

Реальна Війна | Україна | Новини

Лачен пише

Nairaland Pulse | News

Анатолий Шарий

Реальний Київ | Украина

Мир сегодня с "Юрий Подоляка"

Труха⚡️Україна

Николаевский Ванёк

Инсайдер UA

Реальна Війна | Україна | Новини

Лачен пише

Nairaland Pulse | News

Анатолий Шарий

Реальний Київ | Украина

Data Secrets

Технологиялар

Главный по машинному обучению

Сотрудничество: @veron_28

Реестр: clck.ru/3FY3GN

https://telega.in/c/data_secrets

Сотрудничество: @veron_28

Реестр: clck.ru/3FY3GN

https://telega.in/c/data_secrets

TGlist рейтингі

0

0

ТүріҚоғамдық

Растау

РасталғанСенімділік

СенімсізОрналасқан жеріРосія

ТілБасқа

Канал құрылған күніMay 08, 2025

TGlist-ке қосылған күні

May 28, 2024Қосылған топ![Data Secrets [CHAT]](https://static-storm.tglist.com/da1b354b28a3cd215fbc5731e8fd06cb/be92588d-21d4-4364-897a-48b0349874f6.jpg?w=48&h=48)

Data Secrets [CHAT]

3.4K

+2

12.05.202507:37

Пу-пу-пу, тот самый понедельник после майских. Чтобы немного поднять всем настроение, несем с утра приятную новость

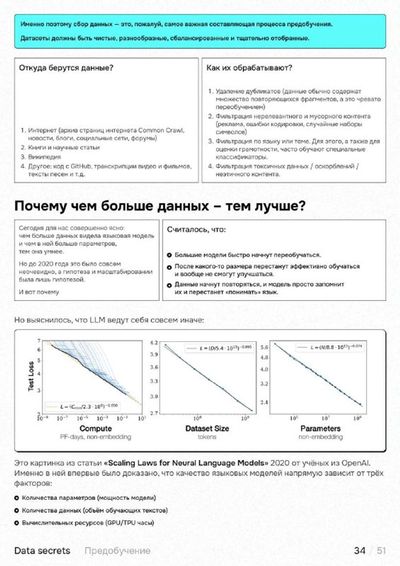

Пока все отдыхали на шашлыках, мы с командой торопились поскорее закончить для вас кое-что особенное. И это – большой конспект по большим языковым моделям.

Внутри – все, что нужно, чтобы от А до Я понять, как работают современные LLM:

– необходимая математика

– механизм внимания и трансформеры со схемами и интуитивными примерами

– все про предобучение

– основы и алгоритмы RL + ризонинг

– ... и даже полноценный гайд по тому, как самостоятельно зафайнтюнить модель.

По секрету: работа над конспектом заняла у нас больше месяца.

500 🔥 и завтра мы выложим сюда полную pdf-версию

Пока все отдыхали на шашлыках, мы с командой торопились поскорее закончить для вас кое-что особенное. И это – большой конспект по большим языковым моделям.

Внутри – все, что нужно, чтобы от А до Я понять, как работают современные LLM:

– необходимая математика

– механизм внимания и трансформеры со схемами и интуитивными примерами

– все про предобучение

– основы и алгоритмы RL + ризонинг

– ... и даже полноценный гайд по тому, как самостоятельно зафайнтюнить модель.

По секрету: работа над конспектом заняла у нас больше месяца.

500 🔥 и завтра мы выложим сюда полную pdf-версию

13.05.202517:42

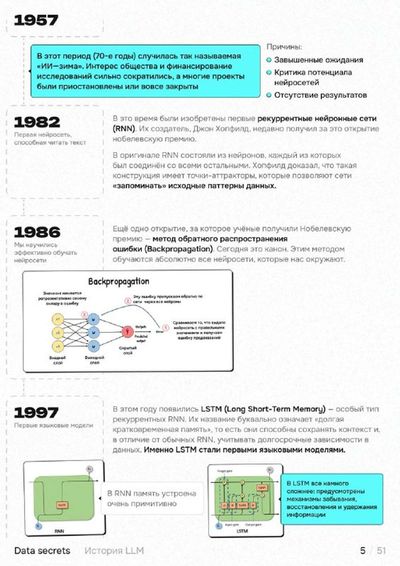

Большой коспект по LLM от нашей команды 👍

Мы долго трудились и наконец готовы представить вам наш большой авторский конспект по языковым моделям. Почти 50 страниц, 7 разделов и все, что нужно, чтобы понять, как работают современные LLM. Внутри:

➖ Краткая история LLM от перцептрона до ризонинг-моделей

➖ Необходимая математика: линал и матанализ на пальцах

➖ Все про механизм внимания и трансформеры от А до Я

➖ Дотошное объяснения процесса предобучения

➖ Практический гайд "Как самостоятельно затюнить модель"

➖ RL – с нуля до ризонинга

Все – в иллюстрациях, схемах и интуитивно понятных примерах.

Сохраняйте, делитесь с друзьями и ставьте ❤️

Мы долго трудились и наконец готовы представить вам наш большой авторский конспект по языковым моделям. Почти 50 страниц, 7 разделов и все, что нужно, чтобы понять, как работают современные LLM. Внутри:

➖ Краткая история LLM от перцептрона до ризонинг-моделей

➖ Необходимая математика: линал и матанализ на пальцах

➖ Все про механизм внимания и трансформеры от А до Я

➖ Дотошное объяснения процесса предобучения

➖ Практический гайд "Как самостоятельно затюнить модель"

➖ RL – с нуля до ризонинга

Все – в иллюстрациях, схемах и интуитивно понятных примерах.

Сохраняйте, делитесь с друзьями и ставьте ❤️

20.04.202508:58

Там Стэнфорд выложили на YouTube свой свежий курс CS336: Language Modeling from Scratch

Это практический курс, в котором вся теория по LLM подается в процессе разработки собственной модели. Получается изучение end-to-end: от обработки данных и архитектуры трансформера до RL и эвала.

Ведет курс опытный профессор университета и сооснователь TogetherAI Перси Лианг.

Ну и главное: курс новый и вся информация актуальна на сегодняшний день. Он даже в самом Стэнфорде еще идет прямо сейчас, так что лекции и код продолжат выкладывать по ходу.

Репозиторий с дз и ноутбуками

Сайт курса

YouTube

Это практический курс, в котором вся теория по LLM подается в процессе разработки собственной модели. Получается изучение end-to-end: от обработки данных и архитектуры трансформера до RL и эвала.

Ведет курс опытный профессор университета и сооснователь TogetherAI Перси Лианг.

Ну и главное: курс новый и вся информация актуальна на сегодняшний день. Он даже в самом Стэнфорде еще идет прямо сейчас, так что лекции и код продолжат выкладывать по ходу.

Репозиторий с дз и ноутбуками

Сайт курса

YouTube

23.04.202511:39

Anthropic выкатили гайд по вайб-кодингу 😎

23 страницы посвящены тому, как программировать с агентами (в частности, с Claude Code). Собраны советы, best practices, примеры, антипримеры и даже готовые промпты.

Отдельное внимание уделяется безопасности данных и мульти-агентным процессам.

Полезно, если пользуетесь каким-нибудь подобным инструментом каждый день

PDF

23 страницы посвящены тому, как программировать с агентами (в частности, с Claude Code). Собраны советы, best practices, примеры, антипримеры и даже готовые промпты.

Отдельное внимание уделяется безопасности данных и мульти-агентным процессам.

Полезно, если пользуетесь каким-нибудь подобным инструментом каждый день

18.04.202509:03

OpenAI выкатили 32-страничный практический гайд по разработке агентов

Его создавали сами инженеры из продуктовых команд стартапа.

Внутри теоретические основы, шаблоны проектирования, лучшие тактики для безопасного развертывания и мониторинга, а главное много-много примеров.

Забираем мастрид на выходные: cdn.openai.com/business-guides-and-resources/a-practical-guide-to-building-agents.pdf

Его создавали сами инженеры из продуктовых команд стартапа.

Внутри теоретические основы, шаблоны проектирования, лучшие тактики для безопасного развертывания и мониторинга, а главное много-много примеров.

Забираем мастрид на выходные: cdn.openai.com/business-guides-and-resources/a-practical-guide-to-building-agents.pdf

25.04.202515:10

Мотивации пост: сейчас в топ-1 по популярности на Hugging Face висит модель, которую разработала команда… из двух человек

Лаборатория называется Nari Labs, и она действительно состоит всего из двух исследователей. Несмотря на это, на этой неделе они со своей text2speech моделью DIA оставили позади Microsoft, Anthropic, Nvidia и другие корпорации.

Моделька у них правда крутая. В ней всего 1.6B параметров, но она генерирует из текста очень качественные диалоги. Сохраняет даже смех, кашель и вздохи. Плюс, пользователь может управлять эмоциями.

При этом у ребят действительно понятная и красивая карточка модели и хорошо оформленный код на гитхаб. Респект?

Лаборатория называется Nari Labs, и она действительно состоит всего из двух исследователей. Несмотря на это, на этой неделе они со своей text2speech моделью DIA оставили позади Microsoft, Anthropic, Nvidia и другие корпорации.

Моделька у них правда крутая. В ней всего 1.6B параметров, но она генерирует из текста очень качественные диалоги. Сохраняет даже смех, кашель и вздохи. Плюс, пользователь может управлять эмоциями.

При этом у ребят действительно понятная и красивая карточка модели и хорошо оформленный код на гитхаб. Респект?

13.05.202507:31

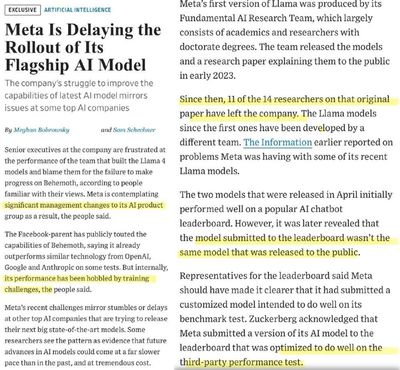

LLM превзошли врачей на новом бенчмарке OpenAI по медицине

HealthBench вышел вчера и состоит не просто из вопросов, а из синтетических диалогов между ассистентом и пользователем. Каждый такой диалог заканчивается сообщением пользователя, на который уже тестируемая модель должна ответить.

Таких диалогов аж 5000 и они разрабатывались совместно с 262 врачами из 26 разных областей. Ответы оцениваются по пяти осям: точность, полнота, понимание контекста, качество коммуникации и следование инструкциям.

Вот какие результаты получились:

➖ Самой эффективной моделью оказалась o3 с результатом 60%. Сразу за ней Grok-3 (54%) и Gemini 2.5 Pro (52%)

➖ У живых врачей результаты сильно ниже. Без опоры на ИИ-ответы люди набирают около 13%.

➖ При этом люди затрудняются даже улучшить ответы ИИ. Смотрите график 3: если дать медикам посмотреть на несколько ответов моделей из сентябрьского поколения и попросить написать на их основе идеальный ответ, люди улучшают средний скор на несколько процентных пунктов (0.31 против 0.28). Но с новыми апрельскими моделями так уже не работает: люди только ухудшают ответы ИИ (0.48 против 0.49).

Кстати, еще менее года назад GPT-3.5 Turbo выбивал всего 16%. Интересно, что будет еще через год.

cdn.openai.com/pdf/bd7a39d5-9e9f-47b3-903c-8b847ca650c7/healthbench_paper.pdf

HealthBench вышел вчера и состоит не просто из вопросов, а из синтетических диалогов между ассистентом и пользователем. Каждый такой диалог заканчивается сообщением пользователя, на который уже тестируемая модель должна ответить.

Таких диалогов аж 5000 и они разрабатывались совместно с 262 врачами из 26 разных областей. Ответы оцениваются по пяти осям: точность, полнота, понимание контекста, качество коммуникации и следование инструкциям.

Вот какие результаты получились:

➖ Самой эффективной моделью оказалась o3 с результатом 60%. Сразу за ней Grok-3 (54%) и Gemini 2.5 Pro (52%)

➖ У живых врачей результаты сильно ниже. Без опоры на ИИ-ответы люди набирают около 13%.

➖ При этом люди затрудняются даже улучшить ответы ИИ. Смотрите график 3: если дать медикам посмотреть на несколько ответов моделей из сентябрьского поколения и попросить написать на их основе идеальный ответ, люди улучшают средний скор на несколько процентных пунктов (0.31 против 0.28). Но с новыми апрельскими моделями так уже не работает: люди только ухудшают ответы ИИ (0.48 против 0.49).

Кстати, еще менее года назад GPT-3.5 Turbo выбивал всего 16%. Интересно, что будет еще через год.

cdn.openai.com/pdf/bd7a39d5-9e9f-47b3-903c-8b847ca650c7/healthbench_paper.pdf

12.05.202518:01

Китайский агент Manus с сегодняшнего дня открыт для всех без листа ожидания

Про самого агента и его особенности мы писали вот тут. Напоминаем, что это реально автономный и универсальный ИИ-агент, который по сути представляет из себя Cursor, Operator и Deep Research в одном флаконе.

Кроме того, агент частично бесплатный: каждый день они выдают по 300 кредитов на пользователя (это примерно одна задача средней сложности), а при регистрации единовременно начисляют 1000 кредитов.

Пробуем первыми тут

P.S. Для входа нужно включить VPN, а затем верифицировать номер телефона. С российскими номерами тоже работает, если выбрать в списке стран Казахстан.

Про самого агента и его особенности мы писали вот тут. Напоминаем, что это реально автономный и универсальный ИИ-агент, который по сути представляет из себя Cursor, Operator и Deep Research в одном флаконе.

Кроме того, агент частично бесплатный: каждый день они выдают по 300 кредитов на пользователя (это примерно одна задача средней сложности), а при регистрации единовременно начисляют 1000 кредитов.

Пробуем первыми тут

P.S. Для входа нужно включить VPN, а затем верифицировать номер телефона. С российскими номерами тоже работает, если выбрать в списке стран Казахстан.

29.04.202518:43

В NotebookLM теперь можно генерировать подкасты из статей на русском языке 🍯

Помните этот легендарный сервис от Google, в котором можно анализировать любые PDF/сайты/видео/ссылки, генерировать по ним конспекты, майндмапы и подкасты?

Так вот: раньше подкасты были доступны только на английском, но с сегодняшнего дня раскатили еще 50 языков. Среди них – русский.

Заходим -> кидаем источник -> тыкаем "Audio Overview" -> получаем подкаст с двумя ведущими по теме в формате вопрос-ответ.

Помните этот легендарный сервис от Google, в котором можно анализировать любые PDF/сайты/видео/ссылки, генерировать по ним конспекты, майндмапы и подкасты?

Так вот: раньше подкасты были доступны только на английском, но с сегодняшнего дня раскатили еще 50 языков. Среди них – русский.

Заходим -> кидаем источник -> тыкаем "Audio Overview" -> получаем подкаст с двумя ведущими по теме в формате вопрос-ответ.

04.05.202509:00

Исследователи из Университета Карнеги-Меллон создали IT-компанию, полностью состоящую из ИИ-агентов. Вот что из этого вышло

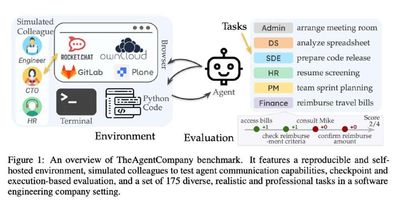

Команда исследователей из CMU запустила необычный эксперимент: они создали автономную виртуальную среду, имитирующую небольшую software компанию, и поместили на "реальные" рабочие места современных LLM-агентов. Все оформили в виде бенчмарка и назвали TheAgentCompany.

По сути агенту необходимо делать все то же, что делает типичный работчик IT (картинка 1): писать код, использовать терминал, рыться в браузере и Google Drive, взамодействовать с коллегами в мессенджере, пользоваться GitLab и Jira. Выполнение всех задач, кстати, оценивалось по чекпоинтам, а не просто "выполнил/не выполнил" (картинка 2) + учитывали итоговую стоимость по токенам.

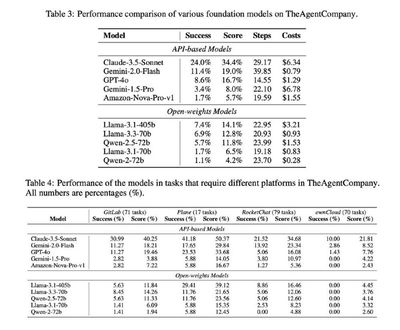

В компании успели поработать Claude 3.5 Sonnet, Gemini-2.0 Flash, GPT-4o, Gemini-1.5-Pro, Llama-3.3 и 3.1, Qwen-2.5 и другие. Задачи покрывали SWE, PM, HR и еще несколько классических сфер. Всего 175 тасок, рассчитанных на 3000 часов труда 20 живых людей.

Результаты в таблицах на картинке 3. Как видите, даже лучший Claude 3.5 Sonnet справляется только с четвертью базовых обязанностей. Следующум идет Gemini 2.0 Flash, но уже с большим отрывом: 11.4%. Все остальные – меньше 9%.

Забавно, что GitLab и кодинг давались агентам довольно легко, а вот самым сложным оказались банальные заполнения форм, браузинг, планирование встреч и общение в мессенджере (им просто не объяснили, что надо мемы отправлять).

Хороший бенч, побольше бы таких

Статья | Код | Сайт (лидерборд внутри) | Результаты экспериментов

Команда исследователей из CMU запустила необычный эксперимент: они создали автономную виртуальную среду, имитирующую небольшую software компанию, и поместили на "реальные" рабочие места современных LLM-агентов. Все оформили в виде бенчмарка и назвали TheAgentCompany.

По сути агенту необходимо делать все то же, что делает типичный работчик IT (картинка 1): писать код, использовать терминал, рыться в браузере и Google Drive, взамодействовать с коллегами в мессенджере, пользоваться GitLab и Jira. Выполнение всех задач, кстати, оценивалось по чекпоинтам, а не просто "выполнил/не выполнил" (картинка 2) + учитывали итоговую стоимость по токенам.

В компании успели поработать Claude 3.5 Sonnet, Gemini-2.0 Flash, GPT-4o, Gemini-1.5-Pro, Llama-3.3 и 3.1, Qwen-2.5 и другие. Задачи покрывали SWE, PM, HR и еще несколько классических сфер. Всего 175 тасок, рассчитанных на 3000 часов труда 20 живых людей.

Результаты в таблицах на картинке 3. Как видите, даже лучший Claude 3.5 Sonnet справляется только с четвертью базовых обязанностей. Следующум идет Gemini 2.0 Flash, но уже с большим отрывом: 11.4%. Все остальные – меньше 9%.

Забавно, что GitLab и кодинг давались агентам довольно легко, а вот самым сложным оказались банальные заполнения форм, браузинг, планирование встреч и общение в мессенджере (им просто не объяснили, что надо мемы отправлять).

Хороший бенч, побольше бы таких

Статья | Код | Сайт (лидерборд внутри) | Результаты экспериментов

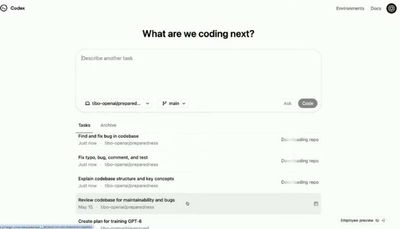

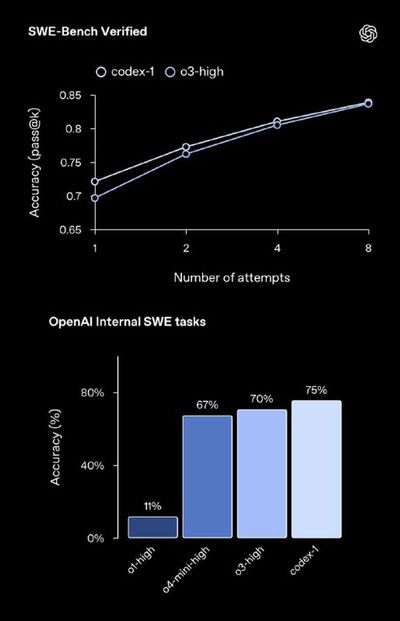

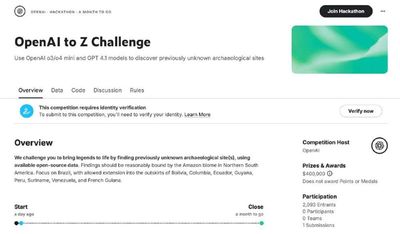

15.05.202512:03

DeepSeek выпустили новую статью, в которой поделились большим списком инженерных хаков по обучению и инференсу моделей

Все, что не убивает, делает сильнее. DeepSeek в условиях санкций на оборудование уже собрали целый список того, что помогает им даже при большом дефиците железа содержать свои системы и обучать модели. Ну и, как истинные любители открытости, всеми этими фичами они решили поделиться просто так.

Топ-3:

1. Multi-head Latent Attention. Это метод сжатия KV-кеша, позволяющий радикально сократить объём памяти, необходимый для хранения ключей и значений из всех attention-голов. Идея в том, чтобы вместо хранения всех сырых K/V векторов для каждого хэдa проектировать их в компактный обучающийся латентный вектор небольшой размерности. В итоге вместо квадратичного роста хранимых данных получается линейный.

2. FP8 Mixed-Precision Training и Inference. Инженерная стратегия, которая позволяет при обучении модели одновременно использовать и более легкие числа в формате FP8, и более точные в FP16 / FP22/FP32. Так мы балансируем между производительностью и стабильностью, а затраты и энергопотребление падают почти в два раза.

3. Multi-Token Prediction. Это значит, что вместо генерации по одному токену модель пытается предсказать сразу несколько (например 2–4) следующих токена. Токены-кандидаты генерирует отдельный легковесный слой, а основная модель их просто сверяет с истинным декодингом. Если совпадают – принимаются без дорасчёта. Это дает ускорение инференса до 1.8х без потерь в качестве.

В статье – еще несколько интересных советов (некоторые мы даже уже разбирали во время опенсорса DeepSeek), так что трушным инженерам советуем почитать полностью.

Мир им: строгие запреты на ввоз железа

Они всему миру: детальные открытые советы по оптимизации этого железа

Респект же

Все, что не убивает, делает сильнее. DeepSeek в условиях санкций на оборудование уже собрали целый список того, что помогает им даже при большом дефиците железа содержать свои системы и обучать модели. Ну и, как истинные любители открытости, всеми этими фичами они решили поделиться просто так.

Топ-3:

1. Multi-head Latent Attention. Это метод сжатия KV-кеша, позволяющий радикально сократить объём памяти, необходимый для хранения ключей и значений из всех attention-голов. Идея в том, чтобы вместо хранения всех сырых K/V векторов для каждого хэдa проектировать их в компактный обучающийся латентный вектор небольшой размерности. В итоге вместо квадратичного роста хранимых данных получается линейный.

2. FP8 Mixed-Precision Training и Inference. Инженерная стратегия, которая позволяет при обучении модели одновременно использовать и более легкие числа в формате FP8, и более точные в FP16 / FP22/FP32. Так мы балансируем между производительностью и стабильностью, а затраты и энергопотребление падают почти в два раза.

3. Multi-Token Prediction. Это значит, что вместо генерации по одному токену модель пытается предсказать сразу несколько (например 2–4) следующих токена. Токены-кандидаты генерирует отдельный легковесный слой, а основная модель их просто сверяет с истинным декодингом. Если совпадают – принимаются без дорасчёта. Это дает ускорение инференса до 1.8х без потерь в качестве.

В статье – еще несколько интересных советов (некоторые мы даже уже разбирали во время опенсорса DeepSeek), так что трушным инженерам советуем почитать полностью.

Мир им: строгие запреты на ввоз железа

Они всему миру: детальные открытые советы по оптимизации этого железа

Респект же

24.04.202517:40

❤️ – говорю спасибо, верю в карму

👍 – не говорю спасибо, <strike>я бессмертный</strike> берегу лимиты

👍 – не говорю спасибо, <strike>я бессмертный</strike> берегу лимиты

26.04.202509:16

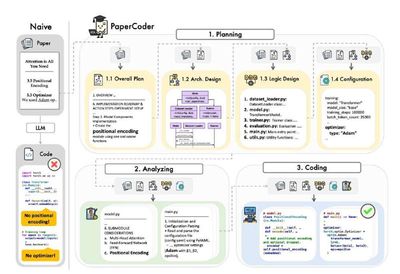

Paper2Code: исследователи из корейского технологического института сделали мульти-агентный фрейморк для автоматической генерации кода по статьям

Боль каждого рисерчера – это статьи, к которым нет кода. Чтобы воспроизвести результат, нужно потратить пол жизни, и то – успех не гарантирован. А код авторы публикуют не так уж и часто. На примере NeurIPS, ICML и ICLR 2024: только 21.2% принятых работ имеют открытые репы.

Здесь авторы предлагают PaperCoder. Это мульти-агентная система, в которой процесс генерации репозитория разбит на три этапа:

1. Планирование. Составляется конспект статьи, UML-диаграммы классов + список файлов. Тут же создается config.yaml с гиперпараметрами и выстраивается план последовательности генерации.

2. Анализ. Здесь для каждого файла из составленного списка формируется file-level analysis — подробное описание целей, входов/выходов, взаимодействий и каких-то специфичных требований, если есть.

3. Ну и сама генерация на основании статьи, фазы планирования и анализа. Бонусом из первых двух пунктов получаем супер-подробную доку.

На каждом шаге работает отдельный агент. Это, по идее, могут быть разные LLM, но здесь по умолчанию на всех шагах стоит o3-mini-high (кроме валидации, там GPT-4o).

Тестировали на работах с тех же ICML/NeurIPS/ICLR 2024. Процент полностью успешной репликации – около 44% против 10-15 у базовых агентов. Если анализировать вручную, то в среднем для успешного запуска нужно менять всего 0.48 % строк. А еще PaperCoder давали потрогать исследователям, и в 85% случаев те сказали, что это лучше, чем писать с нуля, даже если нужно что-то дебажить.

Ирония только в том, что к статье Paper2Code... не выложили код. Но, вроде, обещают "скоро"

Боль каждого рисерчера – это статьи, к которым нет кода. Чтобы воспроизвести результат, нужно потратить пол жизни, и то – успех не гарантирован. А код авторы публикуют не так уж и часто. На примере NeurIPS, ICML и ICLR 2024: только 21.2% принятых работ имеют открытые репы.

Здесь авторы предлагают PaperCoder. Это мульти-агентная система, в которой процесс генерации репозитория разбит на три этапа:

1. Планирование. Составляется конспект статьи, UML-диаграммы классов + список файлов. Тут же создается config.yaml с гиперпараметрами и выстраивается план последовательности генерации.

2. Анализ. Здесь для каждого файла из составленного списка формируется file-level analysis — подробное описание целей, входов/выходов, взаимодействий и каких-то специфичных требований, если есть.

3. Ну и сама генерация на основании статьи, фазы планирования и анализа. Бонусом из первых двух пунктов получаем супер-подробную доку.

На каждом шаге работает отдельный агент. Это, по идее, могут быть разные LLM, но здесь по умолчанию на всех шагах стоит o3-mini-high (кроме валидации, там GPT-4o).

Тестировали на работах с тех же ICML/NeurIPS/ICLR 2024. Процент полностью успешной репликации – около 44% против 10-15 у базовых агентов. Если анализировать вручную, то в среднем для успешного запуска нужно менять всего 0.48 % строк. А еще PaperCoder давали потрогать исследователям, и в 85% случаев те сказали, что это лучше, чем писать с нуля, даже если нужно что-то дебажить.

Ирония только в том, что к статье Paper2Code... не выложили код. Но, вроде, обещают "скоро"

13.05.202509:59

Журналисты раскритиковали стиль управления Альтмана на основании того, как он… готовит

Нет, это не шутка. На выходных вышел еженедельный выпуск кулинарного шоу от Financial Times, гостем стал Сэм Альтман. У себя на кухне он вместе с журналистом готовил обычную овощную пасту.

Казалось бы, ничего не предвещало беды. Но вчера у того же FT внезапно вышла статья, в которой они в пух и прах раскритиковали CEO на основании его… кухни. Вот что пишут:

➖ Альтман неправильно использует оливковое масло. Оно у него якобы очень распиаренное и дорогое (21$), но он на нем жарит, а так делать «нельзя». Весь вкус, мол, теряется, и пользы от дорогого продукта становится не больше, чем он самого дешевого.

➖ На кухне стоит кофемашина за 2к долларов. Опять же очень распиаренная но, по словам журналистов, абсолютно бесполезная и глючная. Они называют эту вещь «деньгами на ветер» и «самой глупой покупкой».

➖ Ну и финалочка: журналистов не устроил нож. Он тоже выглядит дорогим и даже сделанным на заказ, но предприниматель «абсолютно не умеет им пользоваться».

В общем, Альтмана обвинили в том, что он транжира, жертва маркетинга и вообще не умеет управлять ни кухней, ни компанией.

«Его кухня – это мир неэффективности и непонимания. Сжигание денег это основа его жизни и его бизнеса»

Вот так и зови к себе журналистов на обед 🤷♂️

Нет, это не шутка. На выходных вышел еженедельный выпуск кулинарного шоу от Financial Times, гостем стал Сэм Альтман. У себя на кухне он вместе с журналистом готовил обычную овощную пасту.

Казалось бы, ничего не предвещало беды. Но вчера у того же FT внезапно вышла статья, в которой они в пух и прах раскритиковали CEO на основании его… кухни. Вот что пишут:

➖ Альтман неправильно использует оливковое масло. Оно у него якобы очень распиаренное и дорогое (21$), но он на нем жарит, а так делать «нельзя». Весь вкус, мол, теряется, и пользы от дорогого продукта становится не больше, чем он самого дешевого.

➖ На кухне стоит кофемашина за 2к долларов. Опять же очень распиаренная но, по словам журналистов, абсолютно бесполезная и глючная. Они называют эту вещь «деньгами на ветер» и «самой глупой покупкой».

➖ Ну и финалочка: журналистов не устроил нож. Он тоже выглядит дорогим и даже сделанным на заказ, но предприниматель «абсолютно не умеет им пользоваться».

В общем, Альтмана обвинили в том, что он транжира, жертва маркетинга и вообще не умеет управлять ни кухней, ни компанией.

«Его кухня – это мир неэффективности и непонимания. Сжигание денег это основа его жизни и его бизнеса»

Вот так и зови к себе журналистов на обед 🤷♂️

28.04.202507:08

А вы тоже заметили, что после последних обновлений 4o превратился в ванильный раф с сиропом?

Если вы думали, что вам показалось, то нет. Даже Альтман сегодня в твиттере признался, что «что-то мы переборщили с лестью» и пообещал, что на этой неделе все исправят. Пока наслаждаемся комплиментами 😛

Если вы думали, что вам показалось, то нет. Даже Альтман сегодня в твиттере признался, что «что-то мы переборщили с лестью» и пообещал, что на этой неделе все исправят. Пока наслаждаемся комплиментами 😛

Көбірек мүмкіндіктерді ашу үшін кіріңіз.

![D_PEOPLE [Trofimov] Avatar](https://static-storm.tglist.com/4598fec557337ad22d3a369fa3ac3aa9/6eb0249b-4c89-4c76-a2b8-8e3f07a3e58c.jpg?w=64&h=64)