Метаверсище и ИИще

Это не новости, это персональный экспертный взгляд на то, как развивается индустрия ИИ, графики, метаверса, крипты, нейротехнологий и в каком направлении катится все это безобразие.

Для связи: @SergeyTsyptsyn

Для связи: @SergeyTsyptsyn

TGlist rating

0

0

TypePublic

Verification

Not verifiedTrust

Not trustedLocationРосія

LanguageOther

Channel creation dateAug 10, 2017

Added to TGlist

Nov 11, 2023Linked chat

Subscribers

39 877

24 hours

470.1%Week

3891%Month

1 6104.2%

Citation index

0

Mentions1Shares on channels0Mentions on channels1

Average views per post

4 347

12 hours4 404

26.5%24 hours4 347

74.6%48 hours21 7700%

Engagement rate (ER)

3.27%

Reposts68Comments3Reactions74

Engagement rate by reach (ERR)

10.9%

24 hours

32.14%Week

0.46%Month

1.27%

Average views per ad post

3 720

1 hour2 04955.08%1 – 4 hours57915.56%4 - 24 hours3 69099.19%

Total posts in 24 hours

6

Dynamic

4

Latest posts in group "Метаверсище и ИИще"

13.05.202513:56

В общем я развел HunyuanCustom. Этот такой слон в посудной лавке.

С самом экономичном режиме, GPU POOR он считает 5 секунд в течении 40 минут в разрешении 892х540 и жрет 36гиг на A100 (fp8)

Я посчитал их пример. Работает. Лицо переносит.

Но сейчас поставил 1280х720 с полной моделью. 65 гиг и 6 минут на итерацию. Итого 180 минут, то есть 3 часа. На A100.

Может в Комфи будет быстрее, но я не уверен.

https://github.com/Tencent/HunyuanCustom

@cgevent

С самом экономичном режиме, GPU POOR он считает 5 секунд в течении 40 минут в разрешении 892х540 и жрет 36гиг на A100 (fp8)

Я посчитал их пример. Работает. Лицо переносит.

Но сейчас поставил 1280х720 с полной моделью. 65 гиг и 6 минут на итерацию. Итого 180 минут, то есть 3 часа. На A100.

Может в Комфи будет быстрее, но я не уверен.

https://github.com/Tencent/HunyuanCustom

@cgevent

13.05.202513:49

Мне кажется многие недооценивают FramePack, а точнее FramePack Studio.

Это сейчас самый легкий, быстрый и ловкий способ генерить ДЛИННЫЕ image2video.

Вы наконец-то можете уйти от этого короткоствольного монтажа, когда каждые 5 секунд, глаз уже дергается в ожидании смены плана. Тут вы можете задавать планы хоть по 2 минуты. Надо только приноровиться с промптами.И он реально быстрый.

Плюс там промпты с таймкодами, вообще бомба.

Я поставил этот ваш хваленый Hunyan Custom, это чемодан без ручки, впрочем щас напишу про него.

A FramePack Studio пережевывает мои фракталы, тратя 30 секунд на 1 секунду видео.

https://github.com/colinurbs/FramePack-Studio/

@cgevent

Это сейчас самый легкий, быстрый и ловкий способ генерить ДЛИННЫЕ image2video.

Вы наконец-то можете уйти от этого короткоствольного монтажа, когда каждые 5 секунд, глаз уже дергается в ожидании смены плана. Тут вы можете задавать планы хоть по 2 минуты. Надо только приноровиться с промптами.И он реально быстрый.

Плюс там промпты с таймкодами, вообще бомба.

Я поставил этот ваш хваленый Hunyan Custom, это чемодан без ручки, впрочем щас напишу про него.

A FramePack Studio пережевывает мои фракталы, тратя 30 секунд на 1 секунду видео.

https://github.com/colinurbs/FramePack-Studio/

@cgevent

13.05.202513:01

Давно слежу за "умными контактными линзами".

Сам носил линзы 20 лет, пока роговица не сказала пока-пока. Поэтому я крайне скептичен относительно таких девайсов для широкой публики.

Вот это вот ежедневное "тыкание пальцами в глаза" ничего кроме неприятных воспоминаний не приносит. А часть народа просто не сможет это делать. Но это субъективное мнение.

У smart contacts lenses есть две проблемы:

Перегрев и питание.

Вторую задачу ребята из Хайфы зарешали вот такой нашлепкой на веко: это и зарядка по wi_fi, и передатчик данных.

Но, судя по красному оттенку глаза, перегрев все ещё проблема.

Я могу себе представить применение в медицине, реабилитации, у вояк и спецтренингах.

Если вы не биохакер, то вряд ли полезете себе в глаза ради метаверса и дополненной реальности.

Выглядит круто, но вызывает у меня панику.

https://www.blinkenrg.com/

@cgevent

Сам носил линзы 20 лет, пока роговица не сказала пока-пока. Поэтому я крайне скептичен относительно таких девайсов для широкой публики.

Вот это вот ежедневное "тыкание пальцами в глаза" ничего кроме неприятных воспоминаний не приносит. А часть народа просто не сможет это делать. Но это субъективное мнение.

У smart contacts lenses есть две проблемы:

Перегрев и питание.

Вторую задачу ребята из Хайфы зарешали вот такой нашлепкой на веко: это и зарядка по wi_fi, и передатчик данных.

Но, судя по красному оттенку глаза, перегрев все ещё проблема.

Я могу себе представить применение в медицине, реабилитации, у вояк и спецтренингах.

Если вы не биохакер, то вряд ли полезете себе в глаза ради метаверса и дополненной реальности.

Выглядит круто, но вызывает у меня панику.

https://www.blinkenrg.com/

@cgevent

13.05.202508:46

Я тут периодически приподвзвываю о том, что нынешние генераторы 3Д годятся разве что для 3Д-печати и метаверсиков.

Нашел подтверждение последнему и не где-нибудь, а в логове самого метаверса - Meta Horizon Worlds.

В апреле уже прошла новость, что в Horizon Worlds уже можно генерить текстуры и меши с помощью ИИ.

А сейчас Метачка выкатила обнову этого своего 3Д-генератора под названием AssetGen 2.0

Спойлер: кода нет, демо нет бумаги нет, ничего нет. Это инхаус для Horizon Worlds - метаверсика от метачки.

Но выглядит нарядно, пройдите по ссылке, там хорошие черрипики.

По словам метачки, AssetGen 2.0 обеспечивает "значительно улучшенную детализацию и точность" по сравнению с 1.0, включая "геометрическую согласованность с очень мелкими деталями".

На техническом уровне AssetGen 2.0 имеет совершенно иную архитектуру, чем оригинал. AssetGen 1.0 сначала генерировал несколько 2D-изображений предполагаемого ассета, основываясь на промпте, а затем передавал эти изображения другой нейронке, которая генерировала 3Д-сетку. В отличие от этого, AssetGen 2.0 представляет собой одноступенчатую диффузионную 3D-модель, напрямую генерирующую 3Д-ассеты на основе промпта, и которая была непосредственно обучена на большом корпусе 3D-ассетов.

3Д-генерация - это пожалуй самая динамичная область GenAI, там прогресс идет каждый месяц. И не на уровне "вот новая Лора или контролНет", а на уровне самих моделей.

Пойду посмотрю, что Deemos Tech готовят

https://developers.meta.com/horizon/blog/AssetGen2/

@cgevent

Нашел подтверждение последнему и не где-нибудь, а в логове самого метаверса - Meta Horizon Worlds.

В апреле уже прошла новость, что в Horizon Worlds уже можно генерить текстуры и меши с помощью ИИ.

А сейчас Метачка выкатила обнову этого своего 3Д-генератора под названием AssetGen 2.0

Спойлер: кода нет, демо нет бумаги нет, ничего нет. Это инхаус для Horizon Worlds - метаверсика от метачки.

Но выглядит нарядно, пройдите по ссылке, там хорошие черрипики.

По словам метачки, AssetGen 2.0 обеспечивает "значительно улучшенную детализацию и точность" по сравнению с 1.0, включая "геометрическую согласованность с очень мелкими деталями".

На техническом уровне AssetGen 2.0 имеет совершенно иную архитектуру, чем оригинал. AssetGen 1.0 сначала генерировал несколько 2D-изображений предполагаемого ассета, основываясь на промпте, а затем передавал эти изображения другой нейронке, которая генерировала 3Д-сетку. В отличие от этого, AssetGen 2.0 представляет собой одноступенчатую диффузионную 3D-модель, напрямую генерирующую 3Д-ассеты на основе промпта, и которая была непосредственно обучена на большом корпусе 3D-ассетов.

3Д-генерация - это пожалуй самая динамичная область GenAI, там прогресс идет каждый месяц. И не на уровне "вот новая Лора или контролНет", а на уровне самих моделей.

Пойду посмотрю, что Deemos Tech готовят

https://developers.meta.com/horizon/blog/AssetGen2/

@cgevent

13.05.202508:29

Андрей Карпатый предлагает концепцию LMOS - операционная система, работающая на базе LLM.

Вместо CPU, который перемалывает инструкции на основе байтов, тут LLM, которая перемалывает инструкции на основе токенов.

Память (RAM\VRAM) - это контекстное окно, заполненное вместо байтов токенами.

И вот уже вместо программеров им пользуются ВСЕ, просто разговаривая с ним, вместо написания кода и инструкций.

Мы теперь сами себе вайбсисадмины.

@cgevent

Вместо CPU, который перемалывает инструкции на основе байтов, тут LLM, которая перемалывает инструкции на основе токенов.

Память (RAM\VRAM) - это контекстное окно, заполненное вместо байтов токенами.

И вот уже вместо программеров им пользуются ВСЕ, просто разговаривая с ним, вместо написания кода и инструкций.

Мы теперь сами себе вайбсисадмины.

@cgevent

13.05.202504:11

Рендер или видео?

Тесла Оптимус. В реальном времени.

@cgevent

Тесла Оптимус. В реальном времени.

@cgevent

12.05.202520:23

Это вам за то, что не молитесь!

И не дЫшите маткой... по схеме на стене...

@cgevent

И не дЫшите маткой... по схеме на стене...

@cgevent

Reposted from: Data Secrets

Data Secrets

12.05.202519:22

Китайский агент Manus с сегодняшнего дня открыт для всех без листа ожидания

Про самого агента и его особенности мы писали вот тут. Напоминаем, что это реально автономный и универсальный ИИ-агент, который по сути представляет из себя Cursor, Operator и Deep Research в одном флаконе.

Кроме того, агент частично бесплатный: каждый день они выдают по 300 кредитов на пользователя (это примерно одна задача средней сложности), а при регистрации единовременно начисляют 1000 кредитов.

Пробуем первыми тут

P.S. Для входа нужно включить VPN, а затем верифицировать номер телефона. С российскими номерами тоже работает, если выбрать в списке стран Казахстан.

Про самого агента и его особенности мы писали вот тут. Напоминаем, что это реально автономный и универсальный ИИ-агент, который по сути представляет из себя Cursor, Operator и Deep Research в одном флаконе.

Кроме того, агент частично бесплатный: каждый день они выдают по 300 кредитов на пользователя (это примерно одна задача средней сложности), а при регистрации единовременно начисляют 1000 кредитов.

Пробуем первыми тут

P.S. Для входа нужно включить VPN, а затем верифицировать номер телефона. С российскими номерами тоже работает, если выбрать в списке стран Казахстан.

12.05.202518:33

Алибаба бахнули в сеть различные пожатые кванты для Qwen 3.

Все это поддерживается в Ollama и LM Studio.

Полная коллекция версий и форматов тут:

https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f

@cgevent

Все это поддерживается в Ollama и LM Studio.

Полная коллекция версий и форматов тут:

https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f

@cgevent

12.05.202516:18

Вайб-Фракталинг.

Я пробежался по интернетику, в поисках быстрого визуализатора Мандельбалба и нашел либо старые ацкия программы для виндовс 10-летней давности. Либо хитрые примеры на ShaderToy, где его рендерят как 3Д-шейдер.

А так чтобы с крутилками и в вебе - не нашел.

Ну думаю, пора развайбкодироваться.

Лучше всего показал себя Gemini 2.5 - почти с первого раза, нормальные крутилки параметров, управление мышкой.

o4 тупила, 4o выдала корявый дизайн, без управления мышкой, плохими слайдерами в духе юникса из 90х.

Но я просто взял скриншот из Гемини и сунул его в o4 - и она быстро прозрела.

Короче, за часок на навайбкодил крутилку Мандельбалба прямо в браузере на стероидах WebGL. Учитывая, что Мандельбалб задается итеративно по формуле для следующей точки типа Z = Z**N + C, где Z и С просто 3Д-вектора, Гемини проделал отличную работу, написав аппроксиматор поверхностей. Явшоке.

Сейчас мы с Гемини разбираемся с шейдерами.

А пока вот результат работы:

https://cgevent.ru/man1.html

и

https://cgevent.ru/man3.html

На телефоне(андр) тоже работает, если лёжа.

Покрутите Power и Bailout угоните в 2-4, чтобы дырки пропали.

И да, это реалтайм, поэтому качество такое.

@cgevent

Я пробежался по интернетику, в поисках быстрого визуализатора Мандельбалба и нашел либо старые ацкия программы для виндовс 10-летней давности. Либо хитрые примеры на ShaderToy, где его рендерят как 3Д-шейдер.

А так чтобы с крутилками и в вебе - не нашел.

Ну думаю, пора развайбкодироваться.

Write three.js code for interactive webgl simulation of mandelbulb 3d. I want to change all typical parameters like Power or Bailout and see realtime render of mandelbulb.

Лучше всего показал себя Gemini 2.5 - почти с первого раза, нормальные крутилки параметров, управление мышкой.

o4 тупила, 4o выдала корявый дизайн, без управления мышкой, плохими слайдерами в духе юникса из 90х.

Но я просто взял скриншот из Гемини и сунул его в o4 - и она быстро прозрела.

Короче, за часок на навайбкодил крутилку Мандельбалба прямо в браузере на стероидах WebGL. Учитывая, что Мандельбалб задается итеративно по формуле для следующей точки типа Z = Z**N + C, где Z и С просто 3Д-вектора, Гемини проделал отличную работу, написав аппроксиматор поверхностей. Явшоке.

Сейчас мы с Гемини разбираемся с шейдерами.

А пока вот результат работы:

https://cgevent.ru/man1.html

и

https://cgevent.ru/man3.html

На телефоне(андр) тоже работает, если лёжа.

Покрутите Power и Bailout угоните в 2-4, чтобы дырки пропали.

И да, это реалтайм, поэтому качество такое.

@cgevent

12.05.202513:02

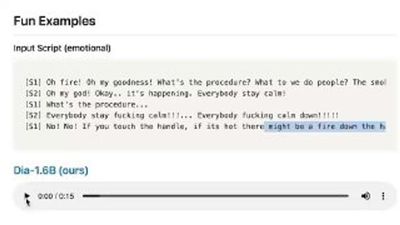

Лето. Питер. AI

26 и 27 июня в Питере пройдет Conversations 2025 — конференция по разговорному и генеративному AI для бизнеса и разработчиков.

Что в фокусе?

🔥 4 трека: технологический, продуктовый, бизнес-треки и, впервые на конференции — стартап-трек, где команды поделятся историями успеха и представят свои GenAI-решения заказчикам и инвесторам.

Немного спойлеров:

🔵 LLM на Госуслугах. Цель, путь и результат. Как ожидания столкнулись с реальностью. Госуслуги x РТ Лабс

🔵 От RnD к продукту: почему крутая модель — еще не фича? Сбер

🔵 Как ATOM обучает автопилот для электромобилей с помощью ML-платформы Selectel: опыт и решения. Selectel & АТОМ

И еще 35+ докладов от экспертов Skyeng, книги билайн, red_mad_robot, Яндекс, Газпромбанк, БКС, Cбер, Битрикс24, Just AI, Artefacto и многих других. Полная программа тут.

Также в эти даты пройдет награждение Generation AI Awards 2025 — первой в России премии, посвященной применению генеративного AI в бизнесе 🦾 Ну как такое пропустить?

📌 Подробности и билеты по ссылке.

Специальный промокод на скидку 10% для наших подписчиков: C25METAVERSE

26 и 27 июня в Питере пройдет Conversations 2025 — конференция по разговорному и генеративному AI для бизнеса и разработчиков.

Что в фокусе?

🔥 4 трека: технологический, продуктовый, бизнес-треки и, впервые на конференции — стартап-трек, где команды поделятся историями успеха и представят свои GenAI-решения заказчикам и инвесторам.

Немного спойлеров:

🔵 LLM на Госуслугах. Цель, путь и результат. Как ожидания столкнулись с реальностью. Госуслуги x РТ Лабс

🔵 От RnD к продукту: почему крутая модель — еще не фича? Сбер

🔵 Как ATOM обучает автопилот для электромобилей с помощью ML-платформы Selectel: опыт и решения. Selectel & АТОМ

И еще 35+ докладов от экспертов Skyeng, книги билайн, red_mad_robot, Яндекс, Газпромбанк, БКС, Cбер, Битрикс24, Just AI, Artefacto и многих других. Полная программа тут.

Также в эти даты пройдет награждение Generation AI Awards 2025 — первой в России премии, посвященной применению генеративного AI в бизнесе 🦾 Ну как такое пропустить?

📌 Подробности и билеты по ссылке.

Специальный промокод на скидку 10% для наших подписчиков: C25METAVERSE

12.05.202511:48

Я с утра как залип на оптических иллюзиях, так и провалился во фрактальную нору.

Держите промпт, поиграйтесь с ним в разных генераторах.

depicted - можно заменить на textured

Также можно попросить chatGPT раскучерявить промпт.

И поиграйтесь со словом Mandelbulb - провалитесь в нору тоже.

Видео - это Сора на тему Mandelbulb.

@cgevent

Держите промпт, поиграйтесь с ним в разных генераторах.

[SUBJECT] depicted within a Fractal Reverberation Field, where repeating motifs spiral and branch infinitely. Leverage intricate fractal patterns in [COLOR1] and [COLOR2], creating a hypnotic sense of order and chaos.

depicted - можно заменить на textured

Также можно попросить chatGPT раскучерявить промпт.

И поиграйтесь со словом Mandelbulb - провалитесь в нору тоже.

Видео - это Сора на тему Mandelbulb.

@cgevent

12.05.202511:11

А вот аппроксимация нашего утлого мира дронами.

Нашел землячков из Каира (10 лет обитал в Дахабе, бился головой об воду на виндсерфинг-флистайле).

Это просто реселлер Bentley (софт, не тачки), Маттерпорта, Цезиума, но с экспертизой.

Они взяли дроны и полетали над пирамидками.

И получили 3D scan of the Great Pyramids of Giza.

Зацените, можно почесть даже надписи и рисунки на стенах.

Сколько осталось до того дня, когда оцифруют всю сушу нашей планеты?

Кстати, в Египте дроны запрещены от слова совсем. Видел, как на детском празднике туристы подняли пластиковый дрончег, за что были приняты в полицию и досрочно покинули страну.

Но я не об этом, а о метаверсике будущего.

https://geomatex.com/

@cgevent

Нашел землячков из Каира (10 лет обитал в Дахабе, бился головой об воду на виндсерфинг-флистайле).

Это просто реселлер Bentley (софт, не тачки), Маттерпорта, Цезиума, но с экспертизой.

Они взяли дроны и полетали над пирамидками.

И получили 3D scan of the Great Pyramids of Giza.

Зацените, можно почесть даже надписи и рисунки на стенах.

Сколько осталось до того дня, когда оцифруют всю сушу нашей планеты?

Кстати, в Египте дроны запрещены от слова совсем. Видел, как на детском празднике туристы подняли пластиковый дрончег, за что были приняты в полицию и досрочно покинули страну.

Но я не об этом, а о метаверсике будущего.

https://geomatex.com/

@cgevent

12.05.202509:52

Простите, я залип на оптических иллюзиях. Чего не сделаешь, чтобы в понедельник не заниматься делами.

Посмотрите на кожанейшую работу - тут не то, что ИИ, тут никаких скриптов и вообще софтов.

Только некривые руки с пятью пальцами.

@cgevent

Посмотрите на кожанейшую работу - тут не то, что ИИ, тут никаких скриптов и вообще софтов.

Только некривые руки с пятью пальцами.

@cgevent

12.05.202509:43

Коль скоро мы тут за графику и мозги в основном, держите довольно хорошо известную оптическую иллюзию.

Один из способов, с помощью которого наша нервная система воспринимает движение, - это так называемый фи-феномен. Эта неврологическая система превращает быстрые последовательности изменений цвета или яркости в нечто более глубокое, например в общее ощущение того, что что-то изменило положение.

Наиболее глазастые и пронырливые могут попросить у chatGPT команду ffmpeg, которая разложит видео на кадры:

ffmpeg -i input.mp4 frames/frame_%04d.png

Они же смогут заметить, что меняется не только цвет, но и по самому краю "ползет" тонкий контрастный контур разного цвета.

Но это не так важно, мы просто наблюдаем, как движение цвета в неподвижной форме, превращается в наших кожаных мозгах в движение самой формы. Кстати, стрелки можете закрыть пальцем, они вообще не играют роли.

А я попросил chatGPT сбацать мне питонг-скрипт, который разбирает видео на кадры и собирает их обратно в рандомном порядке. Иллюзия тут же пропала.

Всем критического мышления с утра.

Кому интересно, тут больше теории.

@cgevent

Один из способов, с помощью которого наша нервная система воспринимает движение, - это так называемый фи-феномен. Эта неврологическая система превращает быстрые последовательности изменений цвета или яркости в нечто более глубокое, например в общее ощущение того, что что-то изменило положение.

Наиболее глазастые и пронырливые могут попросить у chatGPT команду ffmpeg, которая разложит видео на кадры:

ffmpeg -i input.mp4 frames/frame_%04d.png

Они же смогут заметить, что меняется не только цвет, но и по самому краю "ползет" тонкий контрастный контур разного цвета.

Но это не так важно, мы просто наблюдаем, как движение цвета в неподвижной форме, превращается в наших кожаных мозгах в движение самой формы. Кстати, стрелки можете закрыть пальцем, они вообще не играют роли.

А я попросил chatGPT сбацать мне питонг-скрипт, который разбирает видео на кадры и собирает их обратно в рандомном порядке. Иллюзия тут же пропала.

Всем критического мышления с утра.

Кому интересно, тут больше теории.

@cgevent

Records

13.05.202523:59

39.9KSubscribers12.04.202523:59

300Citation index11.05.202513:43

17.1KAverage views per post25.01.202523:59

14.6KAverage views per ad post09.02.202523:59

25.84%ER11.05.202513:42

43.11%ERRGrowth

Subscribers

Citation index

Avg views per post

Avg views per ad post

ER

ERR

Log in to unlock more functionality.