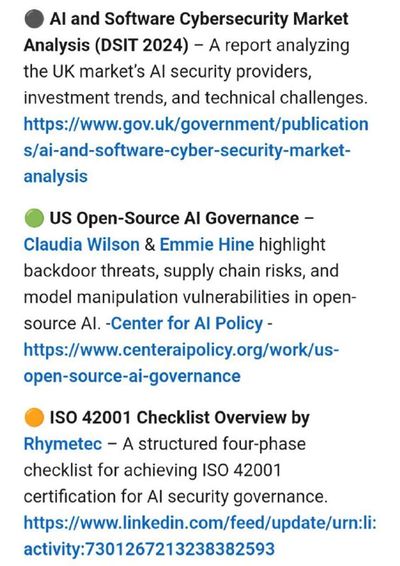

PWN AI

Хроники о небезопасном ИИ

Не нравится? Смени телек.

ML, LLM and cybersecurity vibes. For cybersecurity experts.

On a non-profit basis.

"Мнение автора" != "Мнение компании, где автор работает".

AISecFolder:

https://t.me/addlist/Qdp7zeHWKxAyMjUy

Не нравится? Смени телек.

ML, LLM and cybersecurity vibes. For cybersecurity experts.

On a non-profit basis.

"Мнение автора" != "Мнение компании, где автор работает".

AISecFolder:

https://t.me/addlist/Qdp7zeHWKxAyMjUy

TGlist rating

0

0

TypePublic

Verification

Not verifiedTrust

Not trustedLocationРосія

LanguageOther

Channel creation dateAug 19, 2023

Added to TGlist

Jan 17, 2025Linked chat

Records

01.05.202523:59

3.9KSubscribers24.01.202523:59

200Citation index20.01.202523:59

961Average views per post28.02.202515:38

499Average views per ad post23.01.202514:18

15.71%ER20.01.202523:59

30.69%ERRGrowth

Subscribers

Citation index

Avg views per post

Avg views per ad post

ER

ERR

Log in to unlock more functionality.